Trò chuyện FlowiseAI RAG

FlowiseAI là một công cụ mã nguồn ngắn dành cho các nhà phát triển để xây dựng các luồng điều phối LLM tùy chỉnh & các tác nhân AI. Bạn có thể định cấu hình công cụ FlowiseAI để sử dụng các nút Gaia làm nhà cung cấp dịch vụ LLM.

Điều kiện tiên quyết

Bạn sẽ cần một nút Gaia sẵn sàng cung cấp dịch vụ LLM thông qua URL công khai. Bạn có thể

Trong hướng dẫn này, chúng tôi sẽ sử dụng các nút công khai để cung cấp năng lượng cho plugin Tiếp tục.

| Loại mô hình | URL cơ sở API | Tên model |

|---|---|---|

| Tán gẫu | https://llama8b.gaia.domains/v1 | lạc đà không bướu |

| Nhúng | https://llama8b.gaia.domains/v1 | Danh pháp |

Khởi động máy chủ FlowiseAI

Làm theo hướng dẫn FlowiseAI để cài đặt Flowise cục bộ

npm cài đặt -g flowise

NPX Flowise Bắt đầu

Sau khi chạy thành công, bạn có thể mở http://localhost:3000 để kiểm tra công cụ Flowise AI.

Xây dựng chatbot QnA tài liệu

FlowiseAI cho phép bạn thiết lập trực quan tất cả các thành phần quy trình làm việc cho một tác nhân AI. Nếu bạn chưa quen với FlowiseAI, bạn nên sử dụng mẫu bắt đầu nhanh. Trên thực tế, có rất nhiều mẫu xung quanh OpenAI trên thị trường Flowise. Tất cả những gì chúng ta cần làm là thay thế thành phần ChatOpenAI bằng thành phần ChatLocalAI.

Hãy lấy Flowise Docs QnA làm ví dụ. Bạn có thể xây dựng một chatbot QnA dựa trên tài liệu của bạn. Trong ví dụ này, chúng tôi muốn trò chuyện với một tập hợp các tài liệu trong repo GitHub. Mẫu mặc định được xây dựng với OpenAI và bây giờ chúng tôi sẽ thay đổi nó để sử dụng LLM mã nguồn mở trên nút Gaia.

Tải mẫu QnA Flowise Docs

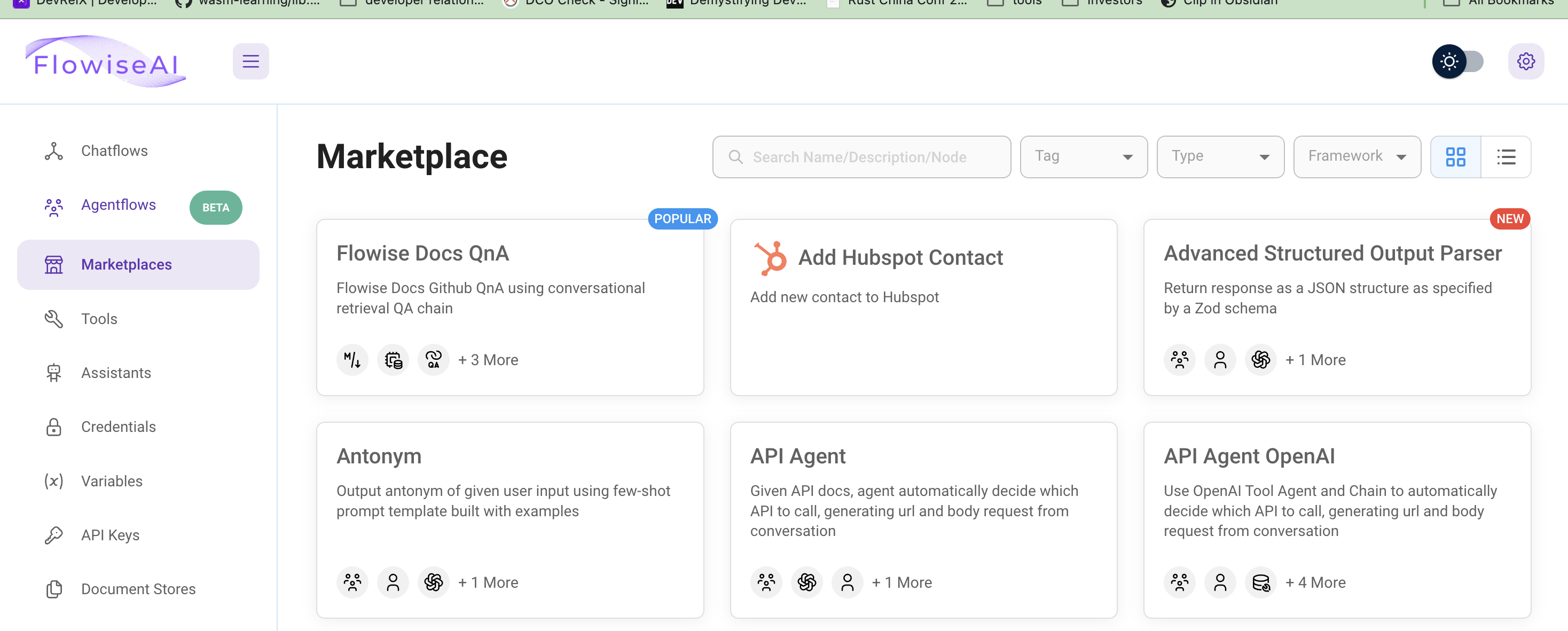

Nhấp vào Thị trường ở tab bên trái để duyệt qua tất cả các mẫu. Mẫu Flowise Docs QnA chúng ta sẽ sử dụng là mẫu đầu tiên.

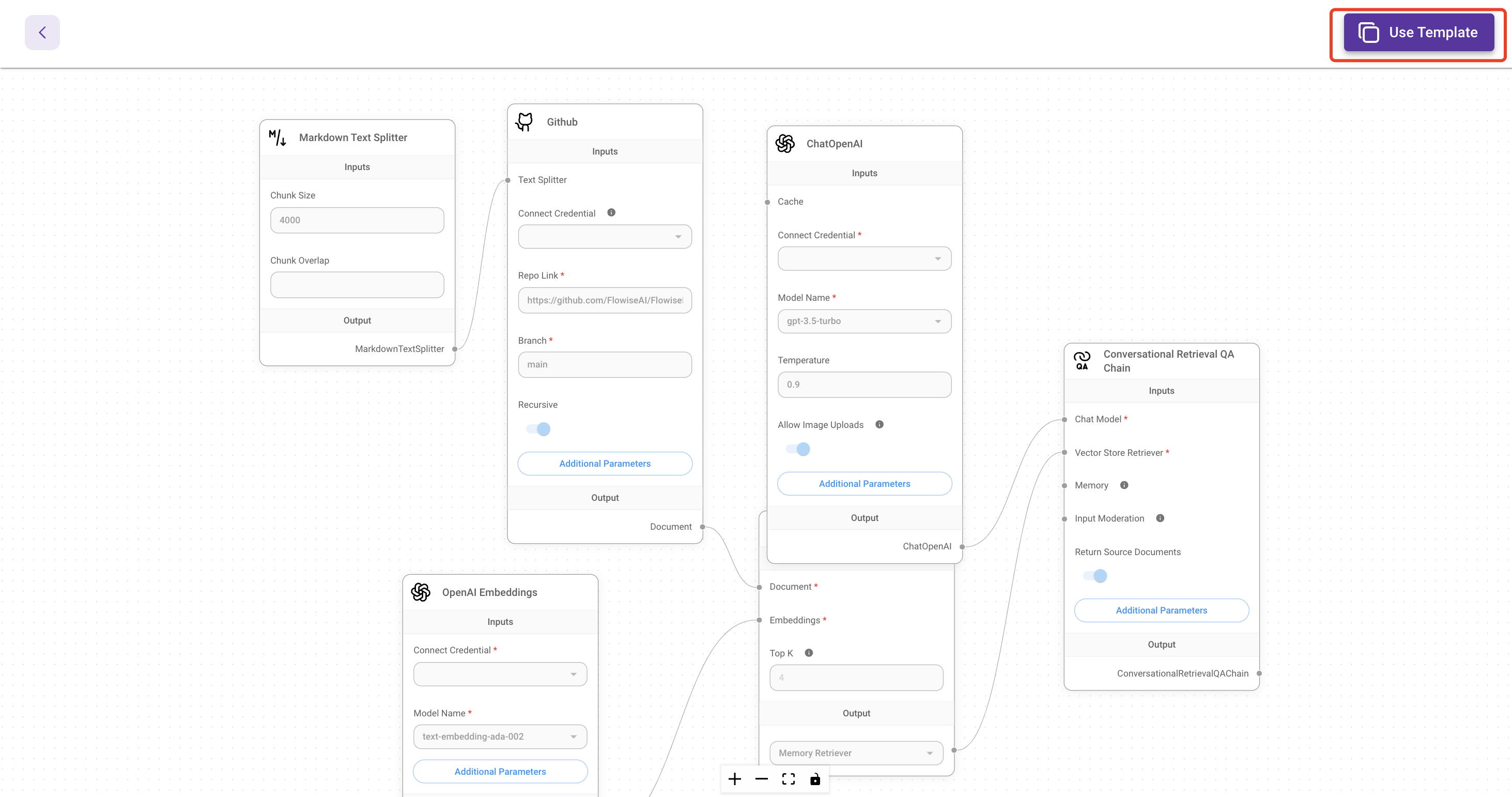

Sau đó, nhấp vào Sử dụng mẫu này ở góc trên cùng bên trái để mở trình chỉnh sửa trực quan.

Kết nối API mô hình trò chuyện

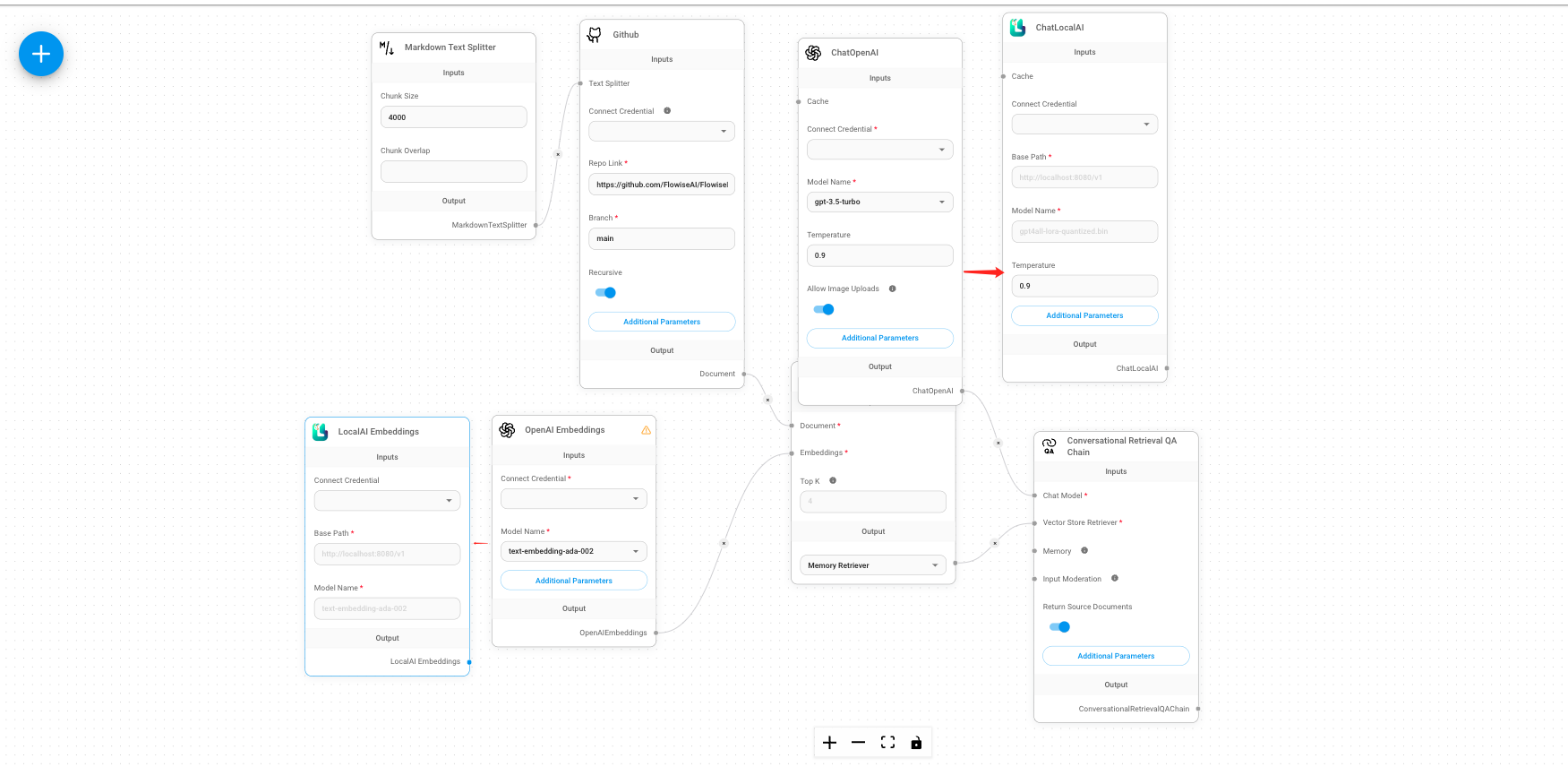

Bạn sẽ cần xóa thành phần ChatOpenAI và nhấp vào nút + để tìm kiếm ChatLocalAI, sau đó kéo ChatLocalAI vào màn hình.

Sau đó, bạn sẽ cần phải nhập

- URL cơ sở nút Gaia

https://llama8b.gaia.domains/v1 - Tên model

lạc đà không bướu

Tiếp theo, kết nối thành phần ChatLocalAI với trường Mô hình trò chuyện trong Chuỗi QA truy xuất đàm thoại thành phần.

Kết nối API mô hình nhúng

Mẫu mặc định sử dụng thành phần OpenAI Embeddings để tạo nhúng cho tài liệu của bạn. Chúng ta cần thay thế thành phần OpenAI Embeddings bằng thành phần LocalAI Embeddings .

- Sử dụng URL cơ sở nút Gaia

https://llama8b.gaia.domains/v1trong trường Đường dẫn cơ sở. - Nhập tên model

nomic-nhúng-văn bản-v1.5.f16trong trường Tên Mô hình.

Tiếp theo, kết nối Nhúng LocalAI thành phần với trường Nhúng trong Lưu trữ vector trong bộ nhớ thành phần.

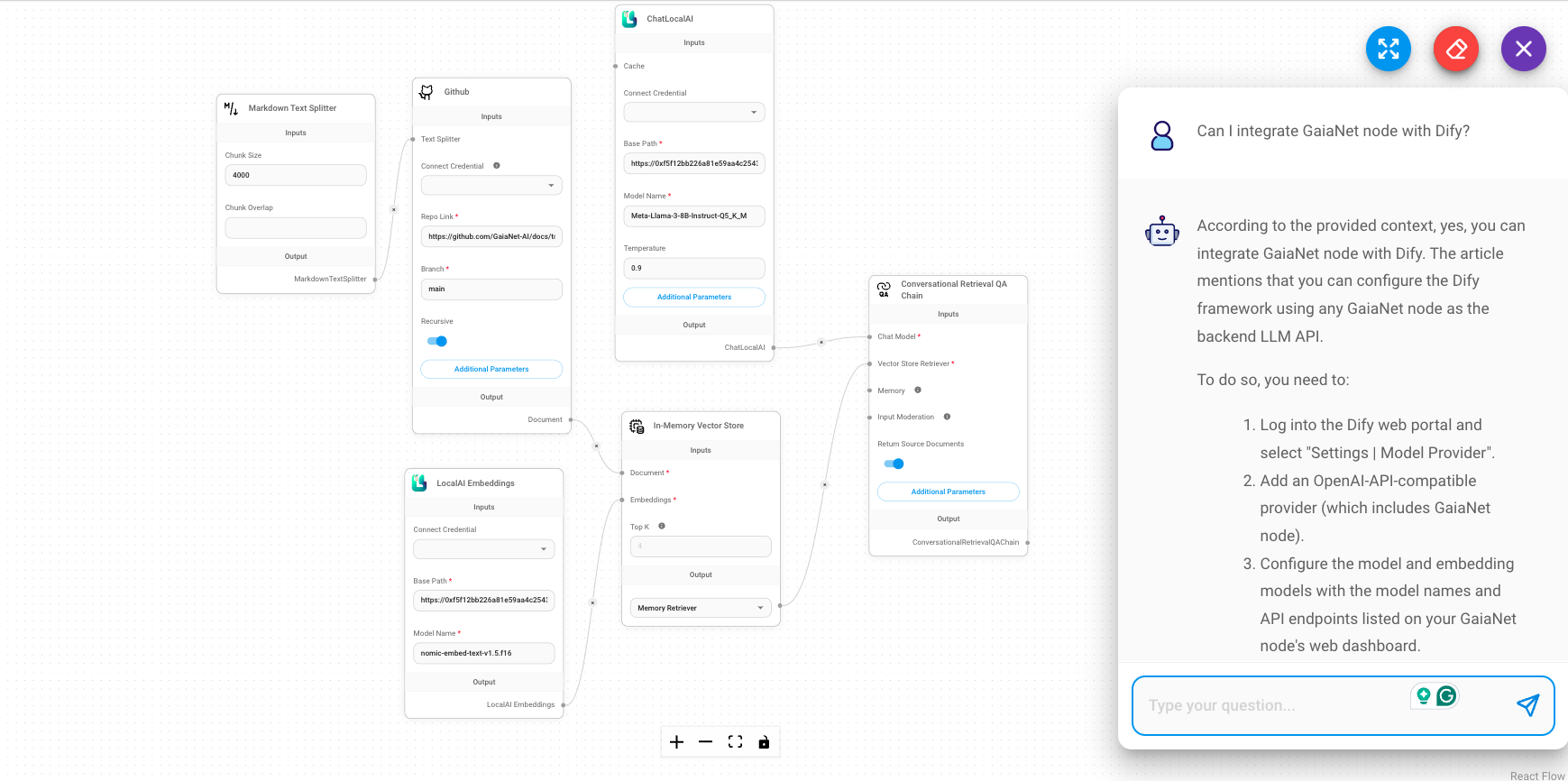

Thiết lập tài liệu của bạn

Sau đó, chúng ta hãy đi qua thành phần GitHub để kết nối ứng dụng chat với các tài liệu của chúng ta trên GitHub. Bạn sẽ cần đặt liên kết GitHub tài liệu của mình vào Liên kết Repo trường. Ví dụ, bạn có thể đặt liên kết tài liệu của Gaia: https://github.com/GaiaNet-AI/docs/tree/main/docs.

Hãy thử

Bạn có thể gửi câu hỏi như "Cách cài đặt nút Gaia" sau khi lưu luồng trò chuyện hiện tại.

Bạn sẽ nhận được câu trả lời dựa trên tài liệu Gaia, có độ chính xác cao hơn.

Ví dụ khác

Có rất nhiều ví dụ trên thị trường Flowise. Để xây dựng một tác nhân Flowise dựa trên Gaia, chỉ cần thay thế thành phần Chat OpenAI và OpenAI Embeddings bằng URL cơ sở Gaia.